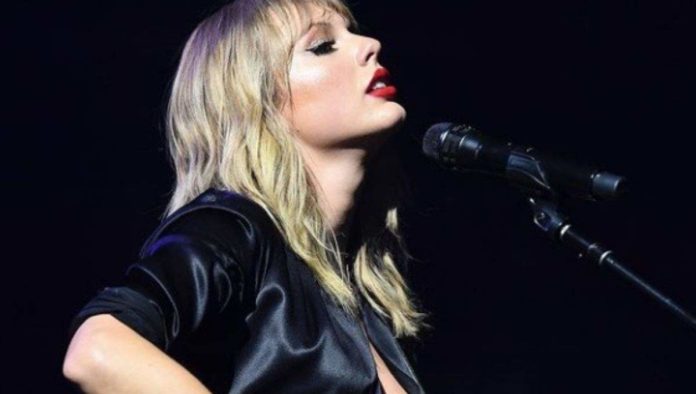

¿Deepfake de Taylor Swift? Aunque la cuenta en “X” de la persona que subió por primera vez las imágenes creadas de Taylor Swift con Inteligencia Artificial (IA), ya fue eliminada, éstas alcanzaron a incendiar la red social y otras donde este contenido deepfake alcanzó a ser amplificado.

Según medios, Taylor estaría decidida en demandar al sitio web que descargó las imágenes de “X” y las subió a su sitio web. Éste es de pornografía donde además de subir fotos y videos cortos reales de actrices en películas que han hecho, también han colgado contenido de ellas creado por la Inteligencia Artificial.

Esto, ha llevado a otro nivel el descontento de usuarios que señalan lo negativo que ha resultado la IA para crear imágenes de mujeres en situaciones pornográficas.

“(Las fotos falsas de Taylor eran) violentamente misógina”, coincidían usuarios de X.

Las imágenes que mostraban a la estrella pop en posiciones sexualmente sugerentes y explícitas, informan que acumularon más de 27 millones de visitas y 260,000 “me gusta” en 19 horas, antes de que se suspendiera la cuenta que las publicó.

En su sitio web, la política de X establece: ‘No puedes compartir medios sintéticos, manipulados o fuera de contexto que puedan engañar o confundir a las personas y llevar a daño (‘medios engañosos’).’

“Este es un ejemplo claro de cómo la IA se está desatando por muchas razones nefastas sin suficientes barreras de seguridad para proteger el espacio público”, dijo Ben Decker, director de Memetica, una agencia de investigaciones digitales, a CNN.

“Las compañías de redes sociales realmente no tienen planes efectivos para monitorear el contenido”, agregó. Las imágenes también circularon en otras plataformas de redes sociales, incluidas Reddit y Facebook.

Un portavoz de Meta, la empresa matriz de Facebook, dijo: “Este contenido viola nuestras políticas y lo estamos eliminando de nuestras plataformas y tomando medidas contra las cuentas que lo publicaron. Continuamos monitoreando y, si identificamos contenido adicional que viola, lo eliminaremos y tomaremos medidas apropiadas”.

Meta, así como sitios para adultos como OnlyFans y Pornhub, también participaron en una herramienta en línea llamada Take It Down, que permite a las personas denunciar imágenes y videos explícitos de sí mismos en internet.

Según la firma de detección de fraudes Sensity AI, la pornografía creada con esta tecnología ahora representa más del 90 por ciento de los deepfakes que circulan en línea.

La policía y los fiscales recibieron más poder para responsabilizar a los perpetradores bajo una enmienda al Proyecto de Ley de Seguridad en Línea en octubre del año pasado, con los distribuidores de deepfakes enfrentando potencialmente penas de prisión bajo las medidas sugeridas.